阿里“通义”大模型炸场WAIC,背后要从一篇论文讲起(2)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

大模型落地难的原因,通常有两个。 其一, 使用成本太高 。以往对于预训练大模型来说,即使微调,依赖的底层资源也不低,如果对效果有进一步要求,则需要继续提升训练数据规模,成本还会进一步提升。 其二, 落地效果有限 。对于部分应用场景而言,大模型并不是一个性价比高的选择,实际使用时为了部署到特定设备上,往往需要模型压缩,导致性能下降明显。 但据介绍,阿里推出的 通义大模型 ,在电商跨模态搜索、AI辅助设计、法律文书学习、医疗文本理解、开放域人机对话等200多个场景中应用落地时,均达到了 2%~10% 的效果提升。 这是怎么做到的?阿里采用了两种方法。 一方面,基于“大一统”思路做出通用大模型,再结合行业知识减少标注成本。 以法律场景为例,此前阿里已经与浙江省高院、浙江大学联合推出了一个能全流程辅助法官审判的AI,目前适用案件达到5000+,帮助法官提升效率达到40%。 这只法律AI实现了“10案连审”的能力,即在30分钟的开庭时间内,辅助法官连续审理10个简单案例,极大地提升了这一流程的效率。 现在,这只AI,已经基于通用大模型+行业knowhow的思路进行迭代。通用大模型基于“大一统”技术,预训练时就已经具备了很强的理解和生成能力,只需再针对特定任务进行简单微调。 以AI学习法律文书时需要完成的“要素化抽取”为例,这里需要AI从大量的电子卷宗中提取有效信息,比如原被告信息、事件描述等,其中涉及的文本理解与抽取能力,就属于通用大模型的能力强项内。 另一方面,研发出多种高质量的大模型“浓缩”技术,可以根据客户的资源情况做快速适配,降低大模型落地的困难。 例如达摩院推出的大模型落地技术S4 (Sound、Sparse、Scarce、Scale) 框架,就包含了各种微调算法和模型压缩算法,本质上是希望将 稀疏化 等技术应用到到百亿量级的大模型中。 基于这一技术,阿里的270亿参数语言大模型PLUG在压缩率达99%的情况下,多项任务的精度损失在1%以内。 这意味着 百亿参数大模型 也可能在几乎不损失精度的情况下进行稀疏化,最终实现 单卡运行 。 值得一提的是,无论是这次发布的多模态统一底座模型 M6-OFA ,还是超大模型落地关键技术 S4 框架,又或是之前发布的通义语言大模型AliceMind-PLUG、多模态理解与生成统一模型AliceMind-mPLUG等核心能力, 均已全部开源 。 但即便具备将通用大模型落地的技术实力,仍然绕不过一个最根本的问题: 为何阿里要选择“大一统”这条技术路线?

激发大模型“通用”的潜力99科技网:http://www.99it.com.cn

“饭圈女孩”,星海浏览器,让你离爱豆更进一步!

“饭圈女孩”,星海浏览器,让你离爱豆更进一步!

《Gee》、《Oh!》、《Run Devil Run》、《The Boys》、《I GOT A BOY》、《Mr.Mr.》...韩国

快资讯2022-09-02

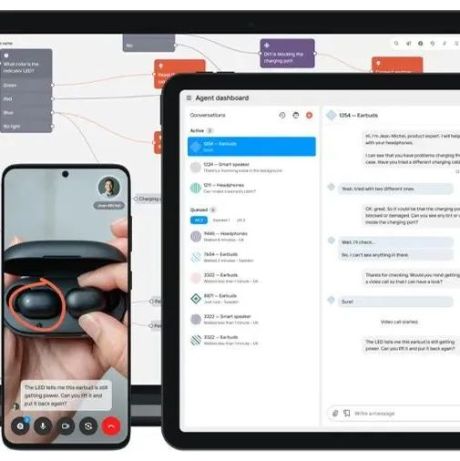

自动化技术支持工具开发商Mavenoid完成3000万美元B轮融资,降低解决硬件问题所需的成本

自动化技术支持工具开发商Mavenoid完成3000万美元B轮融资,降低解决硬件问题所需的成本

Mavenoid采用了技术人员协助的视频交互支持功能和人工智能引导的自助服务功能

快资讯2022-09-01