理论计算机科学家 Boaz Barak:深度学习并非“简单的统计”,二者距离已越来越远(5)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

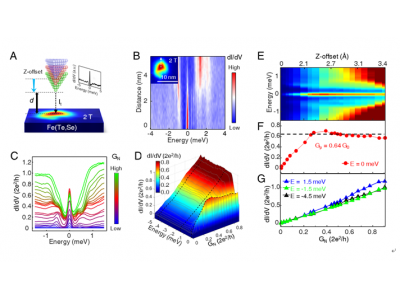

到目前为止,我们只讨论了自监督学习,但深度学习的典型例子仍然是监督学习,毕竟深度学习的 “ImageNet时刻”是来自ImageNet。那么,我们上面所探讨的内容是否适用于监督学习呢? 首先, 有监督的大规模深度学习的出现,在某种程度上是一个历史性的意外,这得益于大型高质量标记数据集(即 ImageNet)的可用性。 可以想象另一种历史:深度学习首先通过无监督学习在自然语言处理方面取得突破性进展,然后才转移到视觉和监督学习中。 其次,有一些证据表明, 即使监督学习与自监督学习使用完全不同的损失函数,它们在“幕后”的行为也相似。两者通常都能达到相同的性能。 在“Revisiting Model Stitching to Compare Neural Representations”这篇论文中也发现,它们学习了相似的内部表示。具体来说,对于每一个 ,都可以将通过自监督训练的深度 d 模型的首 k 层数与监督模型的最后 d-k 层数“缝合”起来,并且使性能几乎保持原有水平。 图注:来自 Hinton 团队论文“Big Self-Supervised Models are Strong Semi-Supervised Learners”的表格。请注意监督学习、微调 (100%) 自监督和自监督 + 线性探测在性能上的普遍相似性 图注:摘自论文“Revisiting Model Stitching to Compare Neural Representations”的自监督与监督模型。左图——如果自监督模型的准确度比监督模型低3%,那么,完全兼容的表示将造成 p·3% 的拼接惩罚(p层来自自监督模型时)。如果模型完全不兼容,那么随着更多模型的缝合,预计准确度会急剧下降。右图——拼接不同自监督模型的实际结果。 自监督 + 简单模型的优势在于,它们可以将特征学习或“深度学习魔法”(深度表示函数的结果)与统计模型拟合(由线性或其他“简单”分类器完成,分离出来在此表示之上)。 最后,虽然是推测,但“元学习”似乎通常等同于学习表示这一事实(详情看论文“Rapid Learning or Feature Reuse? Towards Understanding the Effectiveness of MAML”),可以视为另一个支持本文观点的证据,不管模型表面上优化的目标是什么。

情况2:过度参数化读者可能已经注意到,我跳过了统计学习模型与深度学习模型在实际应用中存在差异的典型例子,即缺少“偏差-方差权衡”以及过度参数化模型出色的泛化能力。 我不详细讲这些例子的原因有两个: 一是如果监督学习确实等于自监督 + 简单的“底层”学习,那么就可以解释它的泛化能力(详情请看论文“For self-supervised learning, Rationality implies generalization, provably”); 二是我认为 过度参数化并不是深度学习成功的关键。 深度网络之所以特别,并不是因为它们与样本数量相比很大,而是因为它们的绝对值很大。实际上, 无监督/自监督学习模型中通常没有过度参数化。即使是大规模的语言模型,它们也只是数据集更大,但这也并没有减少它们性能的神秘性。 图注:在“The Deep Bootstrap Framework: Good Online Learners are Good Offline Generalizers”这篇论文中,研究者的发现表明,如今的深度学习架构在“过度参数化”与“欠采样”状态下表现相似(其中,模型在有限数据上训练多代,直到过度拟合:也就是上图所示的“真实世界”),在“参数化不足”与“在线”情况下也如此(其中,模型只训练一代,每个样本只看到一次:也就是上图中的“理想世界”)

99科技网:http://www.99it.com.cn

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

近日,MetaAI发布了NLLB-200模型,宣布在200多种语言(其中有70%是低资源语言)上

快资讯2022-08-30

推荐资讯

推荐资讯