理论计算机科学家 Boaz Barak:深度学习并非“简单的统计”,二者距离已越来越远(4)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

与上述相反,我们来谈谈教学生一些特定的数学题目(如计算导数),给予他们常规指导及要做的练习。这不是一个正式定义的设置,但可考虑它的一些定性特征: 图注:从IXL 网站学习特定数学技能的练习 学习 一项 技能,而不是近似分布。 在这种情况下, 学生是学习一种技能,而非某个数量的估计器/预测器。 虽然定义“技能”不是一项微不足道的任务,但却是一个性质不同的目标。特别是,即使函数映射练习不能用作解决某些相关任务 X 的“黑匣子”,但我们相信,学生在解决这些问题时所形成的内部表征,仍是对 X 有用的。 越多越好。 一般来说,学生练习更多问题和不同类型问题,会取得更好的成绩。但事实上,“混合模型”——做一些微积分问题和代数问题——不会影响学生在微积分上的表现,反而会帮助他们学习。 “探索”或解锁功能,转向自动表示。 虽然在某些时候解决问题也会出现收益递减,但学生似乎确实经历了几个阶段,有的阶段做一些问题有助于概念“点击”并解锁新功能。另外,当学生们重复某一特定类型的问题时,他们似乎将自己的能力和对这些问题的表述转移至较低的水平,使他们能够对这些问题产生某些以前所没有的自动性。 性能部分独立于损失和数据。 教授数学概念的方法不止一种,即使学生使用不同书籍、教育方法或评分系统学习,但最终仍可学习到相同的材料和相似的内部表示。 一些 问题更难。 在数学练习中,我们经常可以看到不同学生在解决同一个问题时所采取的方法存在很强的相关性。一个问题的难度似乎是固定的,解决难题的顺序也是固定的,这就使学习的过程能够优化。这事实上也是IXL等平台正在做的事情。 深度学习更像统计估计还是学生学习技巧?

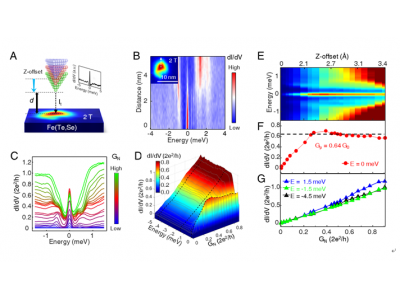

那么,上述两个比喻中,哪个更恰当地描述了现代深度学习,特别是它如此成功的原因呢?统计模型拟合似乎更符合数学和代码。实际上,规范的 Pytorch 训练循环,就是通过如上所述的经验风险最小化来训练深度网络的: 然而,在更深层次上,这两种设置之间的关系并不那么清楚。具体而言,可以通过修复一个特定的学习任务来展开,使用“自监督学习 + 线性探头(linear probe)”的方法训练分类算法,其算法训练如下: 1、假设数据是一个序列 ,其中 是某个数据点(例如具体的图像)、 是一个标签。 2、首先找到一个深度神经网络来表示函数 ,这个函数的训练只使用数据点 而不使用标签,通过最小化某种类型的自监督损失函数。这种损失函数的例子是重建或画中画(从另一个输入 x 的某些部分恢复)或对比学习(找到 使 显著更小,当 是同一个数据点的增量时,并列关系比两个随机点的并列关系要小得多)。 3、然后我们使用完整的标记数据 来拟合线性分类器 (其中 C 是类的数量),使交叉熵损失最小。最终的分类器得出了 的映射。 第 3 步仅适合线性分类器,因此 “魔法”发生在第 2 步(深度网络的自监督学习)。 在自监督学习中,可以看到的一些属性包括: 学习一项技能,而不是逼近一个函数。 自监督学习不是逼近一个函数,而是学习可用于各种下游任务的表示。假设这是自然语言处理中的主导范式,那么下游任务是通过线性探测、微调还是提示获得,都是次要的。 越多越好。 在自监督学习中,表征的质量随着数据量的增加而提高。而且,数据越多样越好。 图注:谷歌 PaLM 模型的数据集 解锁能力。 随着资源(数据、计算、模型大小)的拓展,深度学习模型的不连续改进一次又一次地被看到,这在一些合成环境中也得到了证明。 图注:随着模型大小的增加,PaLM 模型在一些基准测试中显示出一些不连续的改进(上述图中只有三个大小的警告),并解锁了一些令人惊讶的功能,比如解释笑话。 性能在很大程度上与 损失 或数据无关。 不止一种自监督损失,有几种对比性和重建性损失被用于图像。语言模型有时采用单面重建(预测下一个标记),有时则是使用掩蔽模型,其目标是预测来自左右标记的掩蔽输入。 也可以使用稍微不同的数据集,这可能会影响效率, 但只要做出“合理”的选择,常规情况下,原始资源比使用的特定损失或数据集更能预测性能。 有些实例比其他实例更难。 这一点不只限于自监督学习,数据点或存在一些固有的“难度级别”。 事实上,有几个实际证据表明, 不同的学习算法有不同的“技能水平”,不同的点有不同的“难度水平”( 分类器 f 对 x 进行正确分类的概率,随着 f 的技能单向递增,随 x 的难度单向递减)。“技能与难度”范式是对 Recht 和 Miller 等人所发现的“线上准确性”现象最清晰的解释,在我同 Kaplun、Ghosh、Garg 和 Nakkiran 的合著论文中,还展示了数据集中的不同输入如何具有固有的“难度特征”,常规情况下,该特征似乎对不同的模型来说是稳健的。 图注:Miller 等人的图表显示了在 CIFAR-10 上训练并在 CINIC-10 上测试的分类器的线现象准确性 图注:将数据集解构为来自 Kaplun 和 Ghosh 等人在论文“Deconstructing Distributions: A Pointwise Framework of Learning”中的不同“难度概况”点,以获得越来越多的资源分类器。顶部图表描述了最可能类的不同 softmax 概率,作为由训练时间索引的某个类别分类器的全局精度的函数;底部饼图展示了将不同数据集分解为不同类型的点。值得注意的是,这种分解对于不同的神经架构是相似的。 训练 即教学。 现代对大模型的训练似乎更像是在教学生,而不是让模型适应数据, 在学生不理解或看起来疲劳(训练偏离)时采取“休息”或尝试其他方式。Meta 大模型的训练日志很有启发性——除了硬件问题外,还可以看到一些干预措施,例如在训练过程中切换不同的优化算法,甚至考虑“热交换”激活函数(GELU 到 RELU)。如果将模型训练视为拟合数据而不是学习表示,则后者没有多大意义。 图注:Meta 的训练日志节选 下面探讨两种情况:

99科技网:http://www.99it.com.cn

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

近日,MetaAI发布了NLLB-200模型,宣布在200多种语言(其中有70%是低资源语言)上

快资讯2022-08-30

推荐资讯

推荐资讯