全球1000+研究员在Twitter直播训练超大模型??(2)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

21年7月-8月 ,训练完成了GPT-style架构的多语言预训练语言模型,其在13种语言构建的4000亿tokens组成的语料库中进行训练,模型参数为13亿。

21年底-22年初 ,尝试训练千亿参数的多语言预训练语言生成模型,并进行了一系列参数量、数据集、模型架构等方面的探索。期间遇到了很多难题,例如1040亿参数的模型训练不收敛,反而1760亿参数的模型训练很稳定以及数据质量不达标。

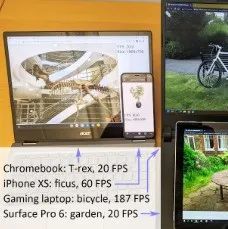

22年3月11日 ,BigScience正式在384张80GB显存的A100上公开训练了1760亿参数量的多语言预训练预训练语言模型 BLOOM (BigScience Language Open-science Open-access Multilingual) ,采取了类似与GPT的Decoder架构。这一项目由30个工作组参与,其中涉及到1000多人报名以及数百名积极参与者。模型预计训练3-4个月,训练数据包括46种语言, 训练期间loss和梯度变化等日志都通过tensorboard的形式在huggingface网站中实时展现了出来,任何人都可以实时跟踪模型训练!

为了让小伙伴不错过大模型BLOOM训练成长的每一天,更是为其开通了twitter账号,从此开启了每日汇报训练进度的日常。从0%开始,到99%、100%,经过111天,模型终于训练完毕。不过,BigScience说让子弹再飞一会,模型会继续训练几天,当然每日的推文就变成了训练进度101%、102%... ... 马上小伙伴们就可以亲自测试BLOOM大模型的效果啦!

虽然最终模型还没有发布,但该模型的checkpoints已经展现了非常酷的效果,可以协助编程例如生成递归函数,纠正语法错误。 每一个人都将会有无限的自由去探索大模型未知的潜力,这会是属于每一个人的一场大模型的“狂欢”。

或将成为AI社区的破局者人工智能对社会产生了根本性的影响,特别是大规模预训练语言模型的研发与应用加速了这种影响的深度和广度,但是大模型的核心技术往往被少数的科技巨头牢牢把控,受限于财务、法律或道德原因,这些资源丰富的研究团体或公司对于模型细节并不十分开放,因此社区对这种变革性技术在构建方式、功能以及进一步改进方面缺乏很好的理解,与此同时在环境、伦理和社会等方面的进一步探索也面临着巨大的束缚。

开放的科学合作才会更加促进学术研究并最终造福整个学术界。

我们看到BigScience成为了人工智能时代新的破局者,BigScience是全球数百名研究人员组成的开放科学项目,这些研究人员作为志愿者秉持着开放、多样、包容乃至造福人类的想法参与了BLOOM(BigScience Language Open-science Open-access Multilingual)大模型的构建以及训练过程。只要你感兴趣,提交表格然后加入他们的Slack频道,你就会成为贡献者的一员。

99科技网:http://www.99it.com.cn

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流

近日,MetaAI发布了NLLB-200模型,宣布在200多种语言(其中有70%是低资源语言)上

元宇宙2022-08-31

推荐资讯

推荐资讯